FLIT614Dans le cadre du séminaire FLIT614, ceci est l’envoi final.

… il n’est pas dit pour autant que je me tairai!

Blogue de Jean-Philippe Maxime Tittley

J’ignore encore un peu aujourd’hui quel média je tentais de décrypter dans ce projet; les textes réunis ici étaient une obligation académique dont je me suis acquitté, somme toute pas trop mal. Ce sont quelques réflexions sur le genre humain, dans une perspective technologique. J’ai écrit ces textes en 2009, et quelques années plus tard, je dois dire que je suis fasciné par les entrefilets et les très brefs reportages radiophoniques qui nous parlent de l’altération de l’humain. Sans me prétendre visionnaire, faut croire que j’avais compris où on s’en allait.

Mais reparlons-en en 2026, si vous voulez bien.

FLIT614Dans le cadre du séminaire FLIT614, ceci est l’envoi final.

… il n’est pas dit pour autant que je me tairai!

Toujours en quête d’une connectivité améliorée qui nous ferait passer d’ Internet — qui constitue possiblement l’apogée en matière d’interconnectivité entre machines – à quelque chose comme humanet, un système d’interconnectivité axé sur l’humain.

Les plus récents avancements technologiques – qu’on semble associer à la miniaturisation, vraisemblablement parce que ça nous arrange de le voir ainsi, davantage que de reconnaître la volonté d’être soi-même relié. Twitter, Facebook, et tous les réseaux sociaux modernes ont pourtant des fonctions qui permettent une mise à jour en temps réel, sur le réseau, à partir d’appareils portables. Autrement dit, nous sommes reliés, mais il demeure un intermédiaire.

Cependant, nous sommes scientifiquement capables de capter les influx nerveux. Certains appareillages orthopédiques tirent profit de cette capacité en effectuant des mouvements « par la seule force de la pensée ». Si cela fait demander à certains quelle est la part d’humanité qui demeure dans ces circonstances (Une personne amputée disposant de prothèses est-elle à 73 % humaine si l’on sait que les organes du corps humain ont une mémoire qui fait partie, sinon de la conscience, à tout le moins de l’inconscient.?!), nous y voyons plutôt une ouverture. An open port.

Le cerveau est un des éléments du système nerveux central. Il émet de ces influx, aussi bien que les terminaisons nerveuses d’un moignon de bras.

Il est donc possible d’envisager une technologie de télépathie, qui tirerait profit de cette émission d’influx, la capterait. Ne reste plus qu’à savoir encoder cela ; la transmission fonctionne déjà. À l’autre extrémité du canal, quelque forme de retransmetteur qui saurait induire la charge appropriée, l’influx, pour que le message se rende. Ainsi, le client, pour parler en termes de réseautage, recevrait l’information émise du serveur.

La majorité des réseaux ont fait leurs débuts en méthode « post », c’est-à-dire que le serveur envoie l’information, généralement en continu, et le client ne retient que ce qui lui est utile. Ainsi fonctionnaient jadis les systèmes de transmission des grands réseaux d’information, principalement parce que la technologie duplex (information échangée dans les deux sens) était difficile à mettre en fonction. CNN, par exemple, émettait sur une fréquence imperceptible à l’écran de son signal satellite tout ce qui passait par sa salle des nouvelles : manchettes, résultats sportifs, cotes boursières, etc. Nous avions chez nous un décodeur qui transmettait le signal télévisuel dans les câbles coaxiaux de la maison, et un signal numérique via un cable RS 232 (l’ancêtre du USB) jusqu’à l’ordinateur. Un logiciel filtrait toute cette information et ne retenait que ce qui était pertinent, générant des fichiers (outputs) régulièrement comme s’il s’agissait d’une page web. (Mais une très très vieille page web!!)

Puis, la conception du réseau se perfectionnant, est apparue ma méthode « get », qui permettait via un modem téléphonique d’envoyer au serveur de CNN l’information que NOUS voulions, et qui nous était ensuite retransmise par satellite, ultra rapidement. Plutôt que d’avoir un flot d’information inutile, à trier et qui engorgeait nos disques durs (de 100 mb à l’époque, soit l’équivalent de quinze MP3 de trois ou quatre minutes), tout était ciblé. C’est encore cette méthode qu’utilisent les FAI (fournisseurs d’accès Internet) dans les régions qui ne sont pas desservies par la câblodistribution.

De la même manière, notre système de transmission d’information nerveuse commencerait probablement par n’exister que sous la forme « post », et sans doute l’induction dans le cerveau du récepteur posera encore problème pour quelques années. Cependant, les technologies des télécommunications sont sans aucun doute assez avancées pour soutenir la méthode « get » pour de tels transferts ; du moment que l’on pourra induire l’information au cerveau, la télépathie SERA possible.

Cela dit, tout encodage numérique est nécessairement restrictif, contraignant. Tout ce qui fait passer l’énergie d’une forme à une autre – qu’on nomme transducer provoque une perte de signal. C’est pourquoi, avant l’avènement du numérique, on tâchait de réduire la longueur des chaines de transmission du signal. Avez-vous déjà fait un appel téléphonique de Windigo (Qc) à Paris (Fr) ? Radio à antenne, antenne à retransmetteur à autre antenne à récepteur-opérateur qui compose pour vous le numéro de téléphone, puis ça part chez Bell, jusqu’à la côte Est, câblage sous-marin (ok, satellite, maintenant!), France télécom, etc. Entre votre « bonjour » et la réponse, il peut facilement se perdre de 15 à 20 secondes.

Les transducers sont donc à éviter comme la peste. La bonne nouvelle, c’est que dans le monde numérique, l’information ne change pas de forme d’énergie. Elle reste en zéros et uns, et on peut récupérer l’information perdue, s’il y en a. Le seul problème qu’il subsiste, c’est que le passage de l’analogique au numérique (l’inverse pose moins problème) occasionne une perte : nécessairement, l’encodage écarte une partie des données, à moins de les reconstituer. Exemple : vous dessinez un rond sur une feuille de papier, que vous numérisez. En apparence, le rond numérisé tel qu’il apparaît à l’écran est le même que celui que vous avez dessiné. Or, si vous utilisez l’outil loupe sur votre logiciel d’imagerie et que vous faites un zoom 400x, vous commencerez à voir apparaître les pixels de votre cercle ; lesquels pixels n’existent évidemment pas si vous regardez votre feuille de papier au microscope 400x. Plutôt vous verrez un peu de la fibre du papier, sans doute, qui n’apparaît pas à l’écran. Ça aussi, c’est un transducer.

Cela est inévitable, à moins de vectoriser votre cercle, dans le logiciel d’imagerie. Alors, le logiciel tentera, au mieux et selon les zones d’ombre de votre trait circulaire, de recréer le plus fidèlement possible le dessin qu’on lui donne à analyser. Et vous pourrez zoomer, zoomer et zoomer encore, vous ne verrez plus que le trait. Jamais de pixels. Au lieu de retenir qu’il y a un carré (pixel) blanc, puis un gris, puis un noir, puis un gris, puis un blanc, et sur la ligne suivante un blanc, un gris, etc… (ce qui est une cartographie de l’image numérisée, en fait, tous les .JPG ; .GIF; .BMP fonctionnent ainsi), votre logiciel retiendra que vous avez tracé un cercle de 0,4 m. à partir du point 304.299 vers la gauche à 40°, diamètre 20 cm, puis que vous avez dévié (vous ne tracez pas les cercles parfaitement) à 40.009°, diamètre 30 cm, avec un force plus intense (donc plus foncé)… etc. Plutôt que le résultat, l’ordinateur déduit de votre dessin la démarche.

C’est la même chose exactement qui procède lorsque vous utilisez le format musical MIDI. Ça sonne « can », mais ça ne peut pas distortionner. Sauf si vous l’imposez. L’erreur n’est plus possible, absolument plus possible (sauf, en ce qui a trait au rythme, si vous faites rouler tous vos logiciels en même temps et que le processeur de l’ordinateur ne fournit plus).

Selon toute vraisemblance, donc, le cercle vectorisé de tantôt sera un peu plus près de la perfection que celui que vous avez tracé. Ça constitue encore un problème, peut-être. La vectorisation peut avoir de la difficulté à générer des erreurs, alors que vous, vous y êtes experts.

Si notre transducer neuronal parvient à vectoriser ce qu’il capte, nous nous rapprochons d’une télépathie parfaite.

Nous continuerions de faire des erreurs, mais l’exprimerions parfaitement. À moins de penser tout croche ?!?!

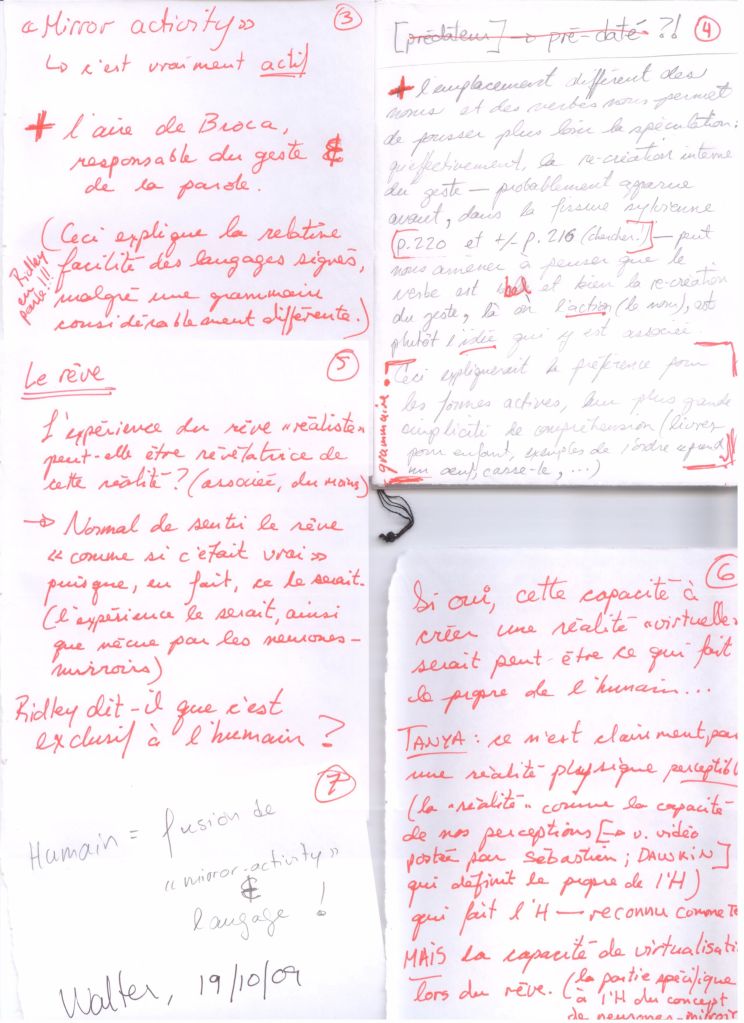

Deux de mes récentes publications portaient sur le passage de l’écrit manuscrit à l’écrit électronique. Je n’aurais évidemment pas la prétention d’affirmer que ma petite expérience puisse mettre en rapport ces deux modes de mise en texte. D’abord le premier des deux ne pouvait être reconnu comme texte que sous l’acception la plus large, conséquemment la moins spécifique. En effet, les images numérisées de mon carnet de notes n’étaient que cela : une représentation graphique plutôt fidèle de notes, c’est à dire des mots, des phrases, mais qui ne présentaient pas l’intrication des divers propos nécessaires à en faire un véritable texte, un tissu d’assertions interreliées formant un tout solide et complet. Je dis « plutôt fidèle », parce que j’ai aménagé mes notes avant de les numériser, d’une part, et parce que le passage du réel concret au réel numérique implique nécessairement un décalage.

Par ailleurs, la publication subséquente, pour laquelle j’admettrais plus aisément la qualité de texte, n’était pas une fidèle traduction de mes notes. La part de fiction qui s’y trouvait visait à donner sens au propos en le contextualisant. Les exemples que j’y convoquais en appelaient davantage à l’effet de réel qu’à la réalité concrète qui est la mienne. Non, vous n’avez pas lu mes confessions. J’aime bien René.

Plaçons ici une parenthèse. Le rapport au carnet, celui qui me tombe des mains souvent lorsque je le relis — non qu’il soit si ennuyeux, mais plutôt qu’il tombe en pièces, ma maîtrise des techniques de reliage étant plutôt sommaire — est fort différent du rapport au clavier. Le toucher. La longueur. La douleur qui m’envahit les métacarpes lorsque je tiens le crayon — je ne sais le tenir que trop fort — ne trouve aucun équivalent au clavier, même dans mes plus frénétiques séances de binarisation d’idées.

Ne serait-ce que pour cette raison, mes écrits manuscrits sont toujours plus sommaires, plus elliptiques. Je les sais toutefois plus sincères. L’effort physique que requiert la mise en texte manuscrite m’incite à faire économie des propos mensongers ou des digressions.

Qui plus est, l’écriture manuscrite me permet de biffer, de raturer, d’annoter. Pas de déplacer, de supprimer (une fois pour toutes cette idée stupide), de remplacer (ou d’intégrer, si je décidais subséquemment de revoir cette phrase et d’y supprimer la parenthèse, considérant que la formulation serait moins gauche si tout se tenait en une phrase succincte). En fait, ni l’une ni l’autre des formes d’écriture n’empêche complètement ou ne permet magiquement aucune de ces actions relatives au texte. Certaines seulement sont facilitées par la rédaction électronique, tandis que d’autres ont des conséquences différentes sur notre rapport au produit final. Admettra-t-on que le texte manuscrit nous semble plus engageant? Que, de par le temps supplémentaire qu’il faut investir pour former les lettres sur le papier (aiguiser le crayon, tourner la page, …), le propos s’en trouve modifié?

Ce ne sont que quelques évidences que je ressasse afin de rappeler aux plus technologiques d’entre nous que les conditions dans lesquelles nous écrivons exercent sur notre propos une influence remarquable, à laquelle nous préférons généralement ne pas réfléchir. Est-ce qu’inconsciemment, notre style rédactionnel se trouverait modifié par le simple fait que certaines lettres sont moins accessibles sur le clavier, ou plus difficiles à former à l’écrit? Nous connaissons tous les prédispositions de l’humain pour la paresse. Utilise-t-on plus souvent les phrases passives à l’écrit électronique, du simple fait que — inconsciemment toujours — l’action nous parait un peu plus virtuelle?

Refermons cette parenthèse. Informée de la courte digression, la question de la traduction suivrait-elle une nouvelle tangente? Il ne s’agirait plus de ne reconnaître le passage d’une forme d’écrit à une autre que comme génératrice de sens, voire de réel, mais d’y voir les conditions de ce passage comme un élément définitoire de cette technologie…

L’idée a certainement déjà été discutée, mais m’est apparue incontournable lors d’une conférence de Serguei Tchougounnikov présentée à l’Université Concordia au cours du mois d’octobre : la traduction est créatrice de sens. En substance, monsieur Tchougounnikov y discutait la teneur des théories du formalisme Russe et du cercle de Bakhtine, telle que modifiée par les traductions qu’en ont effectuées Todorov et Kristeva.

En effet, de nombreuses marques relevant du contexte épistémologique immédiat de ces deux courants de la pensée sont restés inaperçues ou effacées dans les traductions occidentales de ces textes, ce qui a naturellement influencé leur réception en Occident. L’ignorance du contexte et de la généalogie de ces courants a donné lieu à de nombreux malentendus et a fait surgir des images conceptuelles souvent trop éloignées de leurs originaux. C’est ainsi que la généalogie psychologique du formalisme russe, qui remonte à la psychologie allemande du XIXème siècle, est restée jusqu’à ces derniers temps méconnue en Occident où le courant formaliste a été introduit comme radicalement » anti-psychologique « .

Si Tchougounnikov insiste surtout sur la perte d’une nécessaire contextualisation à la théorie, notamment par le vocabulaire employé, lequel serait connoté assez fortement pour en induire la généalogie, nous sommes tentés de voir en tout cela une altération créatrice, au même sens que l’on peut estimer créatrice l’imparfaite réplication génétique ayant cours chez les espèces vivantes. Ainsi serait née, par les voies technologiques de la traduction (lire : réplication), une nouvelle théorie formaliste (non-)Russe. Le sens accordé à cette théorie telle que traduite étant fort différent du sens original, elle a donné lieu à des continuations et des contre-réactions radicales, lesquelles se disséminent toutes deux dans la quasi majorité des courants d’études subséquents. En sorte que l’on puisse avancer que la traduction qui excluait le contexte de production a « évolué » au sens darwinien jusqu’à nos jours.

Si l’on transfère cette idée vers le phénomène de la réécriture, on en vient à voir les multiples états d’un discours (imaginé, oral, manuscrit, typographié, …) comme différentes phases d’évolution d’une même pensée, se perfectionnant — s’adaptant au nouveau contexte.

En apparence anodine, cette idée peut être de grande conséquence pour le présent siècle. En effet, la majorité des textes qui existent ne proposent que deux ou trois états. Nous disposons bien de manuscrits, brouillons et avant-textes pour quelques classiques de nos littératures, mais ces états sont clos, et désormais inféconds ; ils ne produisent plus de nouveaux sens dans le monde actuel. S’ils le font, c’est par un placage du texte sur un nouveau contexte, ou par la projection du lecteur. Encore faut-il, d’ailleurs, que le lecteur moderne retourne au texte, sous une forme le plus souvent inadaptée aux jours actuels et à venir ; le livre ou la numérisation telle-quelle du livre.

Un avenir pour les traducteurs pourrait donc être de faire passer le texte, non pas d’une langue vivante à une autre langue vivante, mais d’un état de texte à un autre, c’est-à-dire de la page-papier à la page-écran. Il ne s’agit pas d’entrer le texte à l’écran, ce qui serait une improductive sottise, mais de réellement traduire le texte, de l’adapter au nouveau mode de distribution, ainsi que le scénariste le ferait au cinéma.

Ainsi les textes (leur discours?) pourraient continuer de vivre, tout en étant assurément productifs. Autrement, nous pourrions craindre leur perte, leur disparition, leur inadéquation au monde. L’Histoire elle-même, relativement inadaptée en marge de Wikipédia, risque de se perdre si elle n’est pas traduite…

Il m’importe de clore sur une note positive. Nos esprits cyniques et souvent prompts à la critique unilatérale verraient aisément ici une nouvelle tâche imposée par l’avènement de l’ère numérique, ou pire, une nouvelle perte découlant de l’accélération sans fin et de la numérisation de nos environnements. J’y vois plutôt une occasion remarquable de traduire l’Histoire, en son sens le plus inclusif, en une langue moderne : une qui soit appropriée à notre contexte. Une réécriture brouillonne de l’Histoire est le plus grand danger que nous courons — auquel nous n’échapperons probablement pas, de toute manière, si la tâche n’est pas intelligemment orchestrée — cependant que sa traduction pourrait être une merveilleuse occasion de la revisiter et de mieux formaliser l’évolution passée, celle à venir.

Malgré que seulement 33% de la population québécoise prévoie se prémunir contre le H1N1, Tony Accurso compte bien se présenter pour se faire administrer le vaccin. Il affirme : « Par les temps qui courent, j’ai bien besoin d’adjuvants…»

Ceci est un message de pré-embarquement.

Je vous avais annoncé dans l’article «Ridley et Tanya» que je menais une petite expérience. Vous alliez en être les cobayes, fallait-il le mentionner, et être informés rapidement de la teneur de l’expérience, dont le présent texte constitue la suite. Ceux parmi vous qui n’ont pas lu «Ridley et Tanya» sont priés de se présenter immédiatement à la porte numéro douze. Les passagers à destination de l’explication, votre départ a été reporté à la fin de ce texte.

Six heures treize. J’ouvre un œil et le cadran de la mini-chaîne m’accorde deux minutes de répit avant de déclencher tout le processus, fort complexe mais extrêmement rapide, qui fera René Homier-Roy me crier qu’il est six heures quinze et qu’à la circulation, Yves, il y en a qui sont un peu gelés, ce matin… Ça m’essouffle déjà.

Il fait bleu, dehors, comme un matin de Noël quand le réveillon a trop duré. C’est octobre, j’ai déjà froid, mais il n’a pas encore neigé. « Heureusement ! », me dis-je, en ouvrant le second œil. Je lève un bras vers la télécommande qui me permettra de faire taire le René Homier-Roy claironnant que Catherine est doooonnc channnnceuuuuuse d’avoir vu hier les Trois Accords, dont, il s’en confesse, il ne pourrait plus se passer depuis qu’il… enfin ! Le faire taire, avant même six heures quinze… Vous comprenez, tout ça, c’est… mécanique. Je lève un bras vers la télécommande et constate que je suis tout courbaturé, bordel, encore, faut vraiment que je change ma paillasse.

Il n’a toujours pas neigé et je me demande, mais quand donc ai-je pelleté la dernière fois ; il me semble… même si je sais que cela n’est pas possible… il me semble que c’était au cours de la dernière semaine. Peut-être hier ? (« Six heures quinze, et, Yves, à la circulation, la journée s’annonce déjà difficile… » Merde !)

Café, douche, toasts, clope, macbook, courriels, Word.

J’émerge, un peu trop lentement, du rêve, devant la page virtuelle qui se brouille sous mes yeux. Et j’ai mal au bras, sans blague, et autour des omoplates. Je me dis que j’ai bien dû rêver à la pelle, parce que plus je m’éveille – c’est un continuum, pas une action terminable – plus je me rends à l’évidence (c’est aussi un continuum) : il n’a pas neigé depuis des mois et je n’ai plus de terrain depuis, à quelques semaines près, la même époque. De toute façon, le plateau est un pays où la neige ne s’accumule pas.

J’ai donc dû forcer du côté du rêve.

* * *

Dans un chapitre de The Agile Gene[1], Matt Ridley expose le concept de neurones-miroirs, tel que découvert en 1991 par Giacomo Rizzolati. En essence, la découverte est que certains neurones « moteurs », en l’occurrence ceux qui s’activent lors d’un mouvement, répondent similairement lorsqu’ils perçoivent ce même mouvement chez un autre individu. D’où l’idée de miroir.

[Insérez ici l’article que j’écrirai la semaine prochaine sur le rapport entre ce que nous pouvons expérimenter et ce que nous sommes incapables d’imaginer]

QUOTE : Recently, Rizzolati’s team has discovered a still stranger neuron, which fires not only when a certain motion is enacted and observed but also when the same action is heard. […] This is remarkably close to finding the neuronal manifestation of a mental représentation : the noun phrase « breaking peanuts ».

Toute la rhétorique de Ridley vise à trouver une explication à l’évolution particulière qu’a subie l’humain au cours du temps, pour en arriver à ce qu’il est aujourd’hui, c’est-à-dire une bestiole capable de considérations, et plus spécifiquement diront les cyniques, de se considérer comme une espèce supérieure à toutes les autres.

Quoi qu’il en soit, les découvertes successives de l’équipe de Rizzolati nous entrainent vers une idée qui me semble particulièrement intéressante : notre cerveau pourrait ne pas distinguer entre l’expérience découlant de perceptions sensorielles directes et l’expérience découlant de la lecture.

Nous savions déjà (ou presque) grâce aux recherche en science cognitive et à tout le courant constructiviste que la lecture est loin d’être un phénomène passif. Or ce que ces nouvelles recherches nous emmènent à penser, c’est que l’apprentissage de l’humain ne se ferait pas sur la base d’une reconstruction et organisation « cérébrale » (disons !) de ce qui est lu, notamment, mais serait plus radicalement fondée sur l’expérience de ce qui est écrit et lu.

En fait, on concevait jusqu’ici l’apprentissage par la lecture comme suit : une première étape s’occupait de la perception, ou la lecture proprement dit, tandis qu’une seconde était plutôt axée sur l’organisation des idées reçues et décodées par la lecture. Plus concrètement, les yeux perçoivent d’abord des taches, lesquelles sont décodées et reconnues comme des lettres ou directement comme des mots selon l’expertise du lecteur, puis le résultat est inséré dans une séquence (la « phrase »). Ensuite, les concepts qui émergent de cette phrase sont organisés dans l’esprit pour éventuellement être retenus, écartés volontairement ou oubliés… et parfois tout simplement incompris.

Évidemment, cette division en étape n’est qu’un modèle nous aidant à comprendre le phénomène ; on sait très bien que toute cette séquence est en fait récursive et qu’il y a de constants retours en arrière, pour redécoder à la lumière de ce qui vient d’être lu et réaménager ce qui vient d’être reconstruit, et c’est sans compter les nombreuses fois où l’application quitte inopinément…

Le petit détour pseudo-théorique n’est pas inutile ici. Les découvertes de Rizzolati et al. nous intéressent dans la mesure où elles suggèrent d’insérer une étape entre les deux déjà énoncées : l’expérience (la recréation du geste). Si les neurones-miroirs sont capables de réagir à la vue d’un geste, comme si ce geste était effectué par soi-même, si encore ils réagissent à la stimulation auditive de la même façon, il n’y a qu’un pas, mentionne Ridley, à dire qu’ils réagissent pareillement à la lecture d’un geste. Entre le décodage et la reconstruction, on vivrait ce que l’on lit.

Fait intéressant à cet égard, l’aire de Broca, zone du cerveau bien connue pour la réalisation de la parole, serait aussi responsable de la perception du geste. (De quoi confirmer tout le champ de la pragmatique en linguistique, ma parole !) Là où le fil se rompt – du moins en apparence – c’est que l’aire de Broca n’est selon toute vraisemblance pas responsable de la perception du langage écrit, qui serait plutôt le fait de l’aire de Wernicke. Il ne faut toutefois pas minimiser les interrelations entre ces deux parties du cerveau et l’idée d’un amoindrissement de la distance entre geste et lecture n’est pas aussi farfelue qu’il n’y paraît, bien que geste et parole soient plus singulièrement liés.

Comme corollaire de cette proximité geste—parole, soumettons l’idée d’une « recréation » facilitée des phrases verbales actives par rapport aux phrases passives, averbales ou purement nominales (Il n’y aurait donc pas que dans la syntaxe que le verbe précède l’objet!). Ceci donnerait une explication à la propension des lecteurs novices à comprendre plus facilement ce type de phrase, et des scripteurs novices à les privilégier.

* * *

Pas étonnant, donc, que le Yves-à-la-circulation m’épuise avec ses embouteillages ; c’est comme si j’y étais. Ce qu’il me dit, je fais davantage que me l’imaginer, je le vis. Tant pis si je n’ai pas touché du volant depuis 6 ans, le concept n’est tout de même pas « plus grand que moi » puisque je l’ai déjà vécu.

À quatorze heures trente-deux, je me dis plutôt ceci : pas étonnant, donc, que j’aie mal partout. Aussi vrai que j’étais congestionné de la vingt de ce matin, j’ai vécu l’expérience de la pelle la nuit dernière (et pas celle qu’on roule) !

Après tout, pourquoi pas ? Si les neurones-miroirs sont capables de recréer l’activité perçue visuellement, auditivement, voire celle perçue via la lettre, si l’on sait rêver en paroles et en gestes, il ne serait pas si surprenant d’apprendre que lors du rêve soient mobilisés les neurones correspondant aux actions auxquelles on rêve.

Si tel devait être le cas, mes courbatures ne trouveraient sans doute pas d’autre explication que ma paillasse ramollie et ma forme physique très discutable, mais peut-être cela nous donnerait-il une piste de réponse à l’assertion de Tanya, est humain qui est reconnu comme tel.

Je veux bien accepter que dans la sphère sociale, cela puisse être avéré, mais ce ne serait que d’un point de vue sociologique, précisément. Que par la perception l’on reconnaisse l’Autre comme étant un frère humain ne me pose aucun problème. Comme le souligne bien Dawkin dans cette vidéo proposée par Sébastien Stravinidis, nos perceptions de la réalité sont modulées à hauteur de ce dont nous avons besoin pour y évoluer. Or si je suis en mesure de percevoir en CP03 une part d’humanité, c’est pour autant que je puisse interagir avec lui, à la hauteur des interactions qui sont les nôtres.

Cela étant, je préfère croire pour moi-même en une forme d’humanité plus intrinsèque : ma capacité à conjuguer le langage et le rêve, c’est-à-dire à mettre en mots une réalité virtuelle en ce qu’elle n’existe qu’en moi, et inversement à expérimenter une réalité qui n’existe qu’en mots. Cette imbrication du langage et du rêve semble en effet n’être possible que chez l’humain, via des neurones-miroirs que l’on croit jusqu’ici bel et bien interconnectés.

Est donc humain qui peut expliciter le fantasme, qu’il soit rêve éveillé ou endormi; est donc humain qui expérimente le sommeil paradoxal.

À dix-huit heures trente huit, alors que je ne peux me remémorer précisément le rêve de la pelle, je me dis que cela est attristant, car les rêves m’échappent de plus en plus fréquemment. Est-ce faute de les expérimenter ? Est-ce parce que René s’exprime trop fort dans mes oreilles, toujours trop tôt ?

Est-ce que je me déshumanise ? Je résisterai à la question en continuant de vous écrire, comme on parle toujours trop vite tout en ne disant rien quand est venu le temps de dire à Florence que c’est terminé.

Lors d’un prochain texte, la question de la traduction comme technologie génératrice de nouveauté. En attendant ce nouvel effort, où il se pourrait bien que soit considéré comme traduction le fait de passer des notes de calepin à texte suivi, je vous invite à commenter la différence que vous percevez entre le présent texte et Tanya et Ridley.

et

Ridley, M. (2003). Nature Via Nurture: Genes, Experience, and What Makes us Human. New York : Harper Collins, 336 p.

Ce serait une présomption douteuse que d’envisager cette conscience de la mécanique temporelle chez les gens d’affaire. Néanmoins, tous les paranoïaques savent bien que les présomptions les plus douteuses sont toujours les plus vraies.

Je fumais une cigarette sur le balcon du bureau tout en réfléchissant à ma productivité de la journée. Je me disais que le patron aurait bien de quoi se plaindre du fait que je dilapidais son argent en sortant fumer une fois l’heure pour cause de stress – comme si ça allait me calmer.

Puis j’ai été pris de panique. Le travail n’est pas le seul lieu où je consume les ressources. Où je brûle mon temps à petit feu. Ça m’a fait penser à mon mensonge de la dernière fois ; que j’allais vous parler de technologie et rapport au temps. Ou l’inverse. Quelle perte de temps!

Si l’on prend pour du cash le vieil adage de Franklin voulant que le temps soit de l’argent, je suis sacrément pauvre. Parce que du temps, je n’en trouve plus. Quelque part, là, entre un livre à lire, un à écrire et un à shipper UPS ground, une ou deux minutes, peut-être.

Qu’importe mes considérations « temporelles », élevons-nous vers de plus édifiants propos : le temps, c’est de l’argent. Ce que Franklin voulait dire est simple : « si en travaillant dix heures tu gagnes dix shillings, en ne travaillant que cinq heures, tu n’en gagneras bien que cinq. » Logique, me direz-vous ; tout notre système économique est basé là-dessus : move your body, earn money[1].

Mais si vous vous souvenez de la perspective de la relativité restreinte dont je vous ai parlé récemment, plus on bouge, moins on vieillit. Et si on vieillit moins, c’est que moins de temps a passé. En fait, c’est plutôt que comme votre vitesse de croisière personnelle se rapprochait de la vitesse maximale atteignable dans l’univers, la loi des proportions vous impose d’avoir eu, en fait, moins de « temps ». Et cela se passe pendant que le reste du monde continue de vieillir, c’est-à-dire de rentabiliser son temps, en en faisant de l’argent. Bordel, direz-vous, on se fait berner!

Oui. Le seul moyen d’éviter cela, c’est au contraire d’hiberner! De laisser les mécanismes travailler pour nous ; deux choix s’offriront alors. Soit vous privilégiez la machine pure (avec ses leviers et ses circuits imprimés), qui travaillera en votre lieu et place pendant que vous vous la coulez douce à vieillir à vitesse constante, tout en vous assurant richesse ; soit vous choisissez les mécanismes économiques en place pour effectuer des placements boursiers qui, si vous avez un peu de veine, croitront du fait que d’autres travaillent, et vieillissent, pendant que vous, vous continuez de vous la couler douce, immobiles au bord de la mer. Le choix n’est pas particulièrement difficile, parce qu’on s’en fout. L’important, c’est d’être immobile !

Ce serait une présomption douteuse que d’envisager cette conscience de la mécanique temporelle chez les gens d’affaire. Néanmoins, tous les paranoïaques savent bien que les présomptions les plus douteuses sont toujours les plus vraies, que les complots les plus farfelus sont les plus probables. Quoi qu’il en soit de cette conscience, les détenteurs d’actifs sont gagnants. (Pousserait-on l’audace jusqu’à dire qu’ils le sont davantage s’ils en sont inconscients, s’étant moins agité les neurones?). Et vous êtes perdants.

Dans une perspective un peu plus créatrice, remarquons que le temps machine est gagnant sur tous les points. Qu’importe la vitesse à laquelle une machine ou un mécanisme opère, son absence de finitude (parce que la guérison lui est plus facile qu’à nous ; remplacez donc une main plutôt qu’une cartouche d’encre, vous!) la garde jeune, et son activation nous fait vieillir, relativement à elle. Machine : 2 ; humain : 0.

Il y a donc plus d’un avantage à la maîtrise du téléchargement de l’individu (ce que vous appellerez sa conscience, mettons) dans un processeur. D’abord, ça vous assure la pérennité, ensuite, vous verrez – si tant est que vous ayez la perception-cartridge – les gens autour de vous vieillir plus rapidement, pour peu que vous vous activiez l’octet.

Maintenant, considérons ensemble quelle influence sur la création artistique peut avoir cette éternelle jeunesse de celui qui s’active. Il va de soi que ça bousille, et les justes eux-mêmes en seront offensés, toutes les conceptions du mercantilisme jusqu’ici énoncées. Évidemment, ça continuera d’assurer la pauvreté aux artistes les plus travaillants. Mais du reste?

(Qu’en) pensez-vous?

J’ai dit que je voulais parler du rapport au temps et c’était faux. (Forcément). J’ai dit que je voulais parler du rapport au temps, alors qu’on ne se rapporte pas au temps. S’il y a quoique ce soit, c’est lui qui nous rapporte. Nous dénonce.

Ce qui était vrai, ça aura été que je disais que je voulais parler du rapport entre le temps et la technologie, ce qui sera tout aussi faux. Le temps ne peut tout simplement pas se rapporter à quoi que ce soit. Il fut trop mou. Il est. Il coulera. Il fluvial. Nulle part ; le temps n’a pas de destination. S’évapore-t-il? Se dissémine-t-il? Cela impliquerait toujours qu’il aille quelque part. Qu’il se transmute, à la rigueur – « Rien ne se perd… » Pourtant, le temps, les heures, disparaissent. Cela se… cela. C. Le temps n’est qu’un vecteur, une force, peut-être. Ou rien du tout.

Est-ce le temps qui coule, qui circule? Ou est-ce nous mortels qui circulons à travers lui? Mais à travers quoi? Le temps est-il tangible? Attendez 15 ans durant votre procès avec possibilité de peine de mort, et le temps le sera sans doute, tangible. Non. Quinze années sont trop longues. Cela redevient intangible. Attendez sans savoir combien de temps vous attendrez. Combien d’heures, combien de jours, combien de décennies. Attendez en sentant l’impatience vous gravir, vous escalader, vous rendre fou, puis indifférent, puis mort. Attendez voir. Combien de temps faut-il pour que le temps nous rattrape?

Tu parles comme si tu te mouvais comme lui. Je l’ai dit. Soit il se meut, soit nous nous mouvons. Pouvons-nous concevoir que le mouvement relève de deux agents à la fois? Que le vecteur, la translation, soit à la fois celui de l’axe et celui de la substance, en laissant des traces. Vous, moi, pas lui – le temps ne laisse pas de traces. C’est nous qui nous détériorons. La matière, telle qu’elle est constituée, se désagrège. En classe, l’attention se désagrège. Emmuré, le mur se désagrège. Les molécules se séparent, se disloquent… C’est la matière, qui change, et on ose appeler ça « temps » !

Et il a fallu en faire le plan. Ou la notion de temps est-elle innée? Quoi qu’il en soit, il a fallu tracer quelque chose comme un schéma, qui puisse nous expliquer sur des quadrants que nous vieillissons. Ah! C’est qu’il existe le temps. Oui, vous savez, cette répétition des rotations de la terre sur elle-même, oui, bon, on sait….

( Je cesse de vous harceler avec ce que nous nous sommes tous dit maintes fois… Oui, parce que l’élite, ça pense à ça. Ça prend le temps, l’élite.

Ça me démangeait. J’avais envie de vous faire sentir que vous perdiez votre temps à lire ceci. Comme si vous ne le perdiez pas à chaque instant, votre temps. (C’est probablement la considération la plus vraie jusqu’ici : ne passons-nous pas notre vie à perdre le temps qu’il nous reste? Je veux dire celui-là qui nous est attribué. Je veux dire : est-ce qu’on ne perd pas son temps à perdre, à chaque minute, une minute du potentiel total de minutes que chacune de nos vies pourrait représenter? Donc, notre temps, on le perd. Il nous est enlevé. C’est un modèle soustractif. 3e quadrant. Et pourtant, ton temps plus mon temps, ça ne fait une équation valable que dans une perspective économique.))

Donc, si l’on accepte tous une certaine forme (plus pressante pour certains que pour d’autres) d’hégémonie du temps, c’est que nous concevons que le temps est donné (Comme dans l’expression « étant donné ». Isn’t this a given? Voyez-y un peu de spiritualisme si ça vous tente, de dogmatisme religieux si ça vous chante, et de putain d’éducation judéo-chrétienne de merde si ça vous dérange). Pourtant, c’est aussi un concept d’une arbitrarité sans nom ; appelons ça la « ».

Le premier qui m’a fourvoyé avec cette notion, c’est Jacquard. Il essayait de m’expliquer la théorie de la relativité restreinte (à ne pas confondre avec l’autre relativité, qui elle n’est pas restreinte), et je me bornais à n’y rien comprendre.

En gros, il s’agit du concept – établi par le même Einstein qui nous a flanqué de la connaissance de la relativité générale – selon lequel qui se meut vieillit moins. De ce que j’en comprends, cela part du principe qu’on ne peut pas transporter la lumière avec soi, malgré qu’elle se meuve, elle aussi.

Jacquard donne l’exemple hautement technologique d’un train avançant à 100 km/h, dans lequel un passager se déplacerait à 4 km/h vers la locomotive, en sorte que sa vitesse par rapport au sol serait de 104 km/h. (Jusqu’ici, rassurez-vous, je comprends tout.)

Ça se complique quand Einstein nous apprend que si la lumière, c’est-à-dire les photons qui la composent et qui ont à la fois statut d’onde et de matière, ne se meut pas avec nous, c’est tout simplement parce que la durée d’un phénomène n’est pas la même pour celui qui est au repos que pour celui qui s’active!

D’accord, j’ai triché. Le raisonnement est plutôt l’inverse de ce que je viens de dire. Tel que je le comprends, ce serait que les ondes lumineuses sont écrasées ou étendues par le mouvement d’un corps. Un peu à la manière de l’effet Doppler qui explique que le son que produit la sirène de l’ambulance soit perçu différemment lorsqu’elle s’approche (ondes écrasées) et lorsqu’elle s’éloigne (ondes étendues), la lumière, bien que mobile, ne peut dépasser 300 000 km/s parce que rien ne le peut [citation requise]. Si donc vous vous déplacez, vous déformeriez l’onde, mais pas la vitesse de la lumière. Capice?

« Allez de Paris à Lyon en prenant le TGV [la métaphore devient stratosphériquement technologique]. Vous avez deux façons de mesurer la durée du parcours : en regardant votre montre au départ puis à l’arrivée ou en regardant l’horloge de la gare de Lyon à Paris puis celle de la gare de Perrache à Lyon. Les deux mesures ne sont en réalité pas rigoureusement identiques : celle de la montre est plus courte que celle des horloges. Bien sûr, l’écart est insignifiant, mais il n’est pas nul. En admettant que le train ait roulé à 200 km/h en moyenne et que votre montre indique une durée de deux heures exactement, la durée indiquée par les horloges, si elles sont capables de la précision requise, est de 2,00000000000002 heures. La quatorzième décimale change. L’écart est si faible que personne ne peut le percevoir. Si élevée soit-elle, la vitesse du TGV est en effet dérisoire face à celle de la lumière. Mais cet écart devient de la première grandeur lorsque les objets observés sont des particules telles que celles que nous recevons du cosmos et dont les vitesses sont du même ordre que celle de la lumière. Pour ces particules, la durée d’un événement qui les concerne, par exemple leur parcours dans l’atmosphère terrestre jusqu’à leur désintégration, est beaucoup plus courte que pour nous qui les regardons passer. »[1]

C’est logique, parce que ces particules ont une vitesse proche de celle de la lumière, donc proche du maximum qu’il soit possible d’atteindre. Il s’agit donc de voir le temps non comme un absolu, mais comme un ratio, par rapport à la vitesse de la lumière. On dira donc

1 seconde

__________________________

300 000 km / seconde

et on sera désolés de ne plus se souvenir de nos notions d’algèbre pour être en mesure de s’expliquer ce que, quand même, on conçoit ; c’est à dire que ce premier calcul dure beaucoup plus longtemps que le suivant :

1 seconde

__________________________

0 km / seconde

Si on retourne l’équation à l’envers, ça reste de l’ordre du ratio, parce que notre univers impose une vitesse maximale, celle de la lumière. Ce faisant, il impose un dénominateur commun par rapport auquel tout temps doit être calculé. Plus le numérateur est grand, plus le ratio est petit, donc plus tu bouges, moins tu vieillis! Reposons-nous avec un gag de physicien :

« … un homme […] sort son chien tandis que son épouse reste à la maison. Le chien court autour de son maître et agite la queue. Au retour, le monsieur a moins vieilli que la dame, le chien moins que le monsieur, et le bout de la queue du chien, moins que le chien! »[2]

Vous ne riez pas? Vous auriez assurément raison de ne pas rire, mais pas pour les raisons que vous voyez de ne pas rire. Pleurez, plutôt, parce qu’Einstein me donne raison : le temps se plie autour de nous. Il n’existe que par l’action. Il n’existe que par nous. Au final, on s’en fout bien que le temps tel qu’on l’admet communément soit une convention un peu arbitraire – bien pratique, pourtant – car s’il ne se passait rien, le temps ne passerait pas.

Alors, oui, le temps est une dimension, et comme toute dimension, elle n’existe que lorsqu’elle est réalisée. De la même manière que la « hauteur » n’existe pas per se, mais seulement si un objet est considéré qui occupe un espace légitimant d’élever cette hauteur. Cette troisième dimension sert à mesurer l’objet, elle n’existerait pas si tout n’était que représentation. C’est donc parce que les événements ont une durée que la dimension « temps » existe, pour mesurer ces événements.

Maintenant, si ces événements se déroulent à une vitesse proche de la limite admissible dans notre univers, la vitesse de la lumière, alors ils durent moins longtemps. Ce paradoxe est insoutenable, mais répond aux lois de la physique que notre civilisation croit avoir identifiées…

Voilà une des relations décrites entre temps et technologie. Reste à l’interpréter!

[2] id. p. 55.